《AI Agents vs. Agentic AI:概念分类、应用和挑战》是美国康奈尔大学等高校研究团队推出的,深度剖析了AI Agents和Agentic AI这组易混淆的核心概念,探讨智能体技术发展中的堵点及解决思路。

为解决上述难题,开发者引入多种技术手段。例如,RAG(检索增强生成)技术可减少幻觉问题;因果建模可提升推理能力;多智能体记忆架构(如向量记忆)增强信息共享效率;更强的规划机制(如思维树)可优化多步骤决策。这些技术将助力智能体技术的突破。

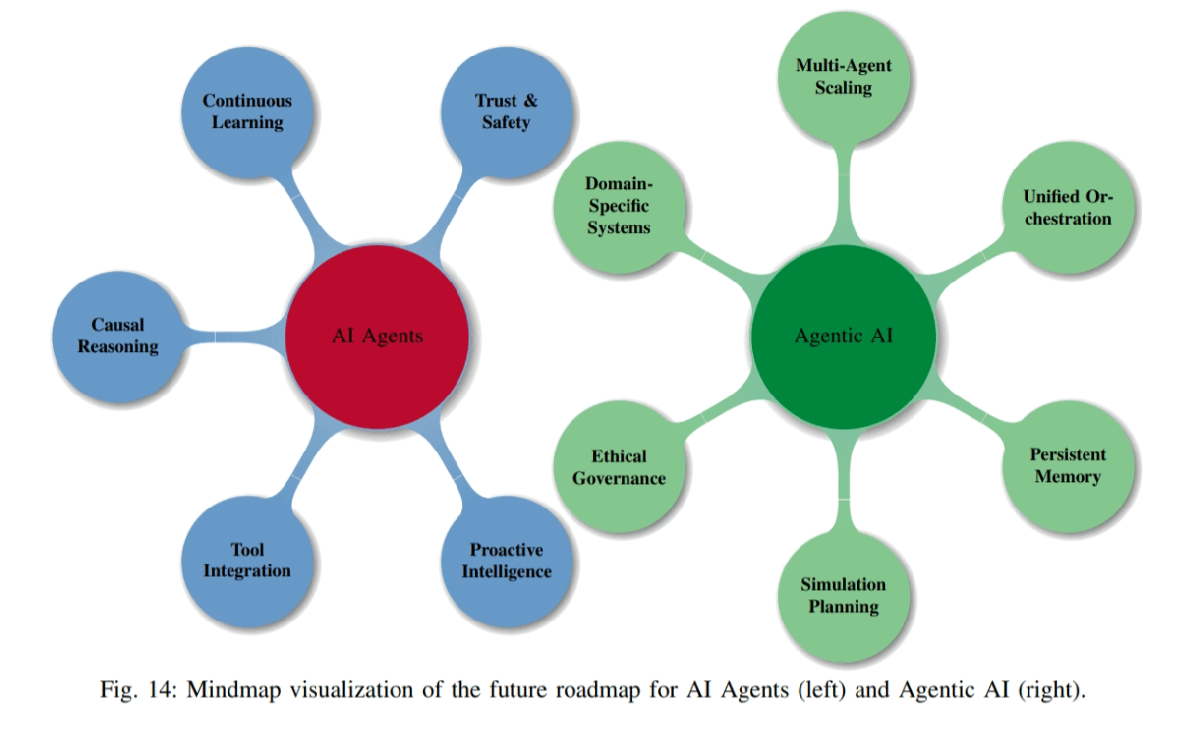

AI Agents将基于模块化设计和智能能力提升,逐步演变为具备“主动智能”的智能体,自主规划和决策。Agentic AI的多智能体协作框架将进一步成熟,形成具备高度组织能力的“系统智能”,为AI的发展带来新的机遇和突破。

核心概念

AI Agents:AI Agents是基于AI技术的自主软件系统,在特定环境中独立感知、决策和执行任务。核心特征包括:

- 自主运行:AI Agents独立完成任务,不需要人工实时监督。支持自动开始工作,基于内置的智能算法做出决策,实现7×24小时不间断运行。

- 目标明确:每个AI Agents都围绕特定目标工作。把大任务拆解成小步骤,智能安排执行顺序,持续评估完成质量。

- 环境感知:AI Agents能理解文字、语音、图像等多种信息。根据实时情况调整工作方式,连接其他系统协同工作。

- 持续进步:AI Agents从每次工作中学习经验,基于分析成功和失败的案例优化自己。记住用户喜好,自动调整工作方式,在推荐系统等服务中越用越智能。

Agentic AI:与 AI Agent 不同,Agentic AI是新型的智能架构,是指多个AI Agent基于协同机制组成的智能系统,具备处理复杂任务的高级能力。核心特征包括:

- 多智能体协作架构:多个专业化Agent分工合作,基于智能通信机制实现复杂任务的高效执行。

- 高级任务规划能力:具备递归拆解任务、多路径推理和动态调整能力,应对复杂问题。

- 分布式记忆系统:结合全局共享记忆与个体专属记忆,支持跨智能体的知识调用与存储。

- 元智能体协调机制:基于中央调度、质量监控和安全沙盒,确保多Agent协作的可靠性与安全性。

- 自进化能力:智能体间共享经验并优化协作策略,推动系统整体性能持续提升。

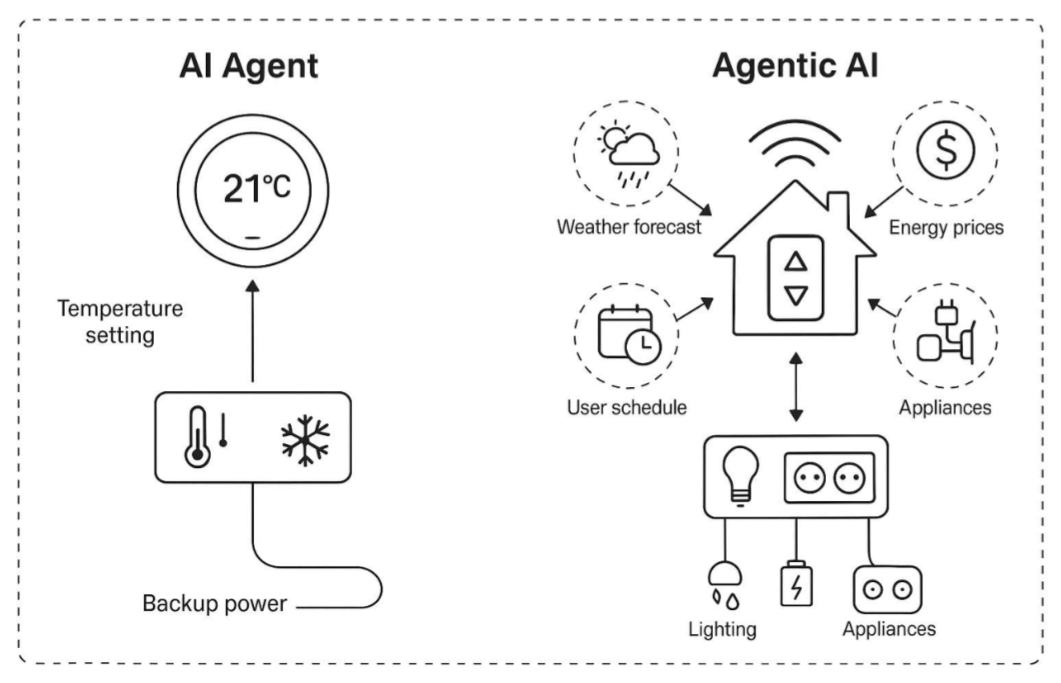

研究团队基于智能家居系统案例阐释了 AI Agent 和 Agentic AI 之间的区别。

这张对比图生动呈现了AI技术从单一功能向系统智能的演进:左侧的AI Agent(如智能恒温器)代表基础智能单元,专注于独立执行特定任务(如温度调节),具备有限的自学习和规则响应能力;右侧的Agentic AI系统构建一个多智能体协作网络(集成天气预测、能源管理、安防等模块),基于实时数据共享和动态决策实现跨领域协同优化(如结合电价与天气预判自动调节家居环境)。二者的本质差异在于,前者是”功能执行者”,后者是”系统决策者”,标志着AI从孤立工具向具备组织级智能的生态中枢跨越,为应对复杂场景(如智能城市、工业物联网)提供关键技术范式。

应用领域

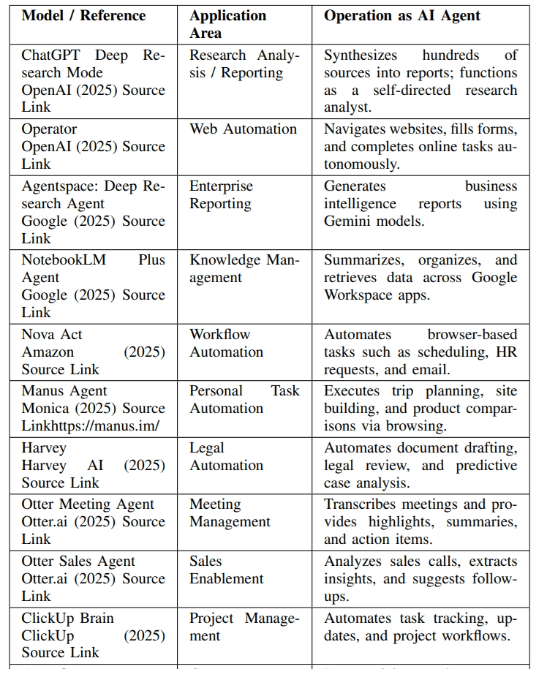

AI Agent应用领域:

- 客户服务自动化::智能客服系统能够根据预设规则和用户输入,快速准确地回答常见问题,提高客户满意度。

- 日程安排:自动分析用户的时间表,合理安排会议和活动,避免时间冲突。

- 数据总结:自动提取和总结大量数据中的关键信息,生成简洁的报告。

- 电子邮件过滤:自动分类和优先级排序,帮助用户管理高流量的电子邮件。

- 个性化内容推荐:根据用户的行为和偏好,推荐个性化的内容,如新闻、音乐、视频等。

- 自动文档处理:自动提取和处理文档中的信息,生成摘要或报告。

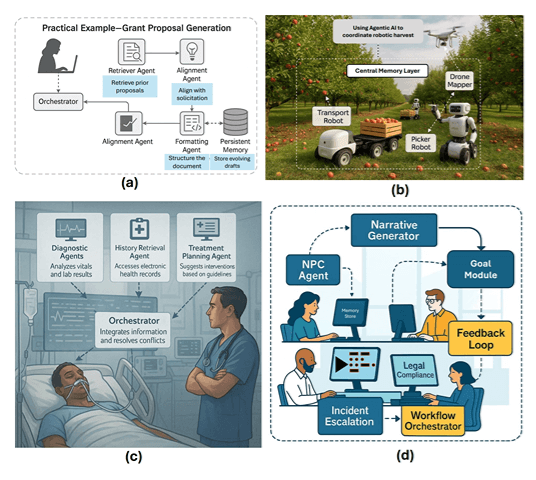

Agentic AI应用领域:

- 研究自动化:自动化科研流程,包括文献检索、实验设计、数据分析等。

- 机器人协调:协调多机器人系统,完成复杂的任务,如物流配送、环境监测等。

- 医疗决策支持:提供医疗诊断、治疗方案推荐和患者监测等服务。

- 智能交通系统:优化交通流量,管理自动驾驶车辆的协调和调度。

- 供应链管理:优化供应链中的资源分配、物流调度和库存管理。

- 智能能源管理:优化能源消耗,管理智能电网和分布式能源资源。

面临的挑战

AI Agents:继承大模型短板(幻觉、推理浅层)、缺乏长期记忆与目标主动性。具体表现在以下几个方面:

- 缺乏因果理解:AI Agents 难以区分相关性和因果关系,导致在面临新情况时表现不佳。

- LLM 固有限制:如幻觉问题、提示敏感性、推理浅层化、知识截止日期、偏见问题,生成不准确信息,影响可靠性。

- 不完全的智能体属性:AI Agent的自主性不足、主动性缺乏、社交能力弱限制应用范围和功能。

- 缺乏长期记忆:难以进行多步骤规划和处理任务失败,限制了在复杂环境中的适应能力。

Agentic AI:多智能体错误传播、缺乏统一标准、安全与伦理风险。具体表现在以下几个方面:

- 错误传播:单个Agent的错误输出会基于协作链被多层放大,污染整个系统决策。

- 系统稳定性:多Agent动态博弈易导致决策震荡,任务成功率随Agent数量增加显著下降。

- 协议碎片化:不同框架用独立通信协议(如gRPC/JSON-RPC),导致跨平台互操作性差。

- 验证困难:多Agent交互路径组合爆炸式增长,现有测试工具仅能验证简单协作链。

- 扩展瓶颈:超过7个Agent协同效率骤降,硬件性能成为大规模部署的硬约束。

技术解决方案

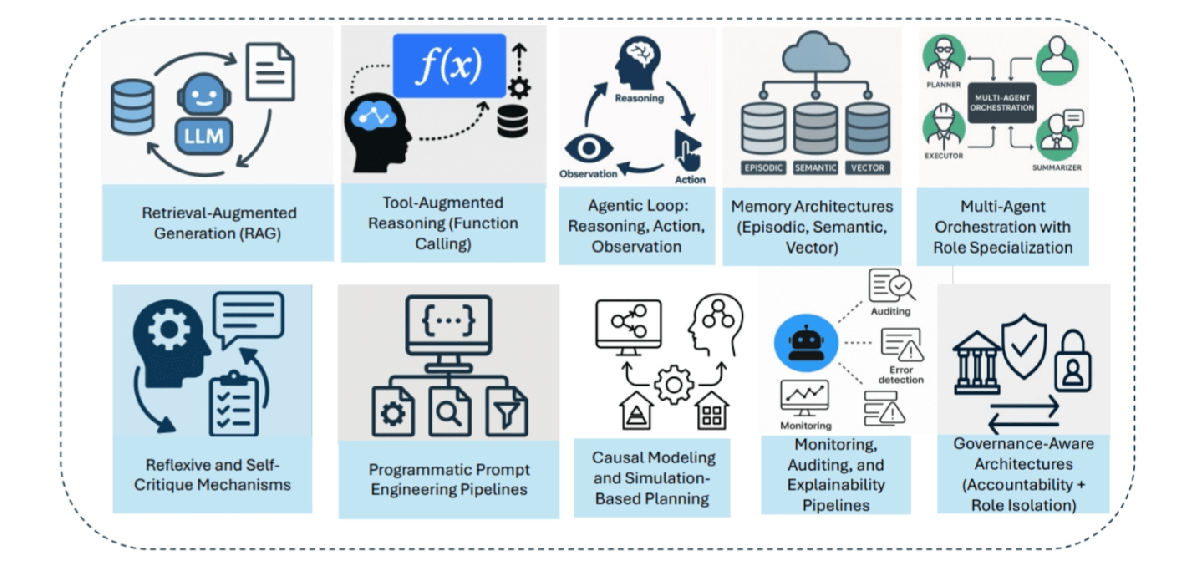

解决AI Agents与Agentic AI所面临多样问题的10大解决方案:

- 检索增强生成(RAG):基于实时检索外部知识库,为智能体提供事实核查能力,减少幻觉输出(如客服Agent调用最新产品数据库应答)。

- 工具增强推理:赋予智能体API调用权限(如查询天气/股价),扩展其解决问题的能力边界(如投资Agent自动获取财经数据辅助决策)。

- 智能体行为循环:建立”推理-行动-观察”的闭环机制(如写作Agent先列提纲再分段生成),提升决策严谨性。

- 分层记忆架构:用情景记忆(短期会话)+语义记忆(长期知识)+向量记忆(快速检索)的三层存储体系。

- 角色化多Agent编排:像公司部门般分工(如MetaGPT的CEO/CTO角色),基于专业化提升协作效率。

- 自我批判机制:设置验证Agent(如审计员角色)交叉检查输出,降低错误传播风险。

- 程序化提示工程:用模板化提示词(如”你是一名资深医生”)规范Agent行为,减少随机性。

- 因果建模:构建因果图区分相关性(如”咳嗽-感冒”)与因果关系,增强推理可信度。

- 可解释性管线:记录完整决策日志(如AutoGen的对话历史),支持故障回溯与责任追溯。

- 治理感知架构:实施沙盒隔离(如金融Agent交易限额)和RBAC权限控制,确保系统安全性。

未来发展方向

AI Agents:从被动响应到主动智能(Proactive Intelligence)。

- 自主决策:不再局限于简单任务执行,基于上下文和目标主动推理,自主规划行动路径(如智能助手主动提醒会议并准备材料)。

- 工具集成(Tool Integration):深度结合外部API、数据库和物理设备(如机器人调用行业知识库或控制机械臂),扩展能力边界。

- 因果推理(Causal Reasoning):超越相关性分析,理解“为什么”,提升决策可靠性(如医疗诊断Agent区分症状因果链)。

- 持续学习(Continuous Learning):基于在线学习和反馈优化(如推荐系统实时适应用户偏好),实现长期性能提升。

- 信任与安全(Trust & Safety):引入可解释性、审计日志和价值观对齐机制,确保AI行为符合伦理且可控。

Agentic AI:从单智能体到系统智能(Systemic Intelligence)。

- 多智能体扩展(Multi-Agent Scaling):构建大规模协作网络(如城市交通管理中的数千个Agent协同优化信号灯)。

- 统一编排(Unified Orchestration):开发标准化通信协议和调度框架(类似Kubernetes之于容器),实现跨平台Agent协同。

- 持久记忆(Persistent Memory):支持长期知识保留(如科研Agent系统积累领域研究历史),避免重复学习。

- 模拟规划(Simulation Planning):在虚拟环境中预演决策(如自动驾驶Agent通过数字孪生测试极端场景),降低现实风险。

- 伦理治理(Ethical Governance):建立多Agent系统的责任追溯机制(如区块链存证),确保符合法律与社会规范。