HunyuanVideo-Avatar是什么

HunyuanVideo-Avatar是腾讯混元团队与腾讯音乐天琴实验室联合研发的语音数字人模型,基于多模态扩散Transformer架构,能生成动态、情感可控以及多角色对话视频。模型具有角色图像注入模块,可消除训练与推理间的条件不匹配,确保角色一致性。音频情感模块(AEM)能从情感参考图像中提取情感线索,实现情感风格控制。面部感知音频适配器(FAA)可实现多角色场景下的独立音频注入。它支持多种风格、物种和多人场景,可应用于短视频创作、电商广告等。

HunyuanVideo-Avatar的主要功能

- 视频生成:用户只需上传一张人物图像和相应的音频,模型能自动分析音频中的情感和人物所处环境,生成包含自然表情、唇形同步及全身动作的视频。

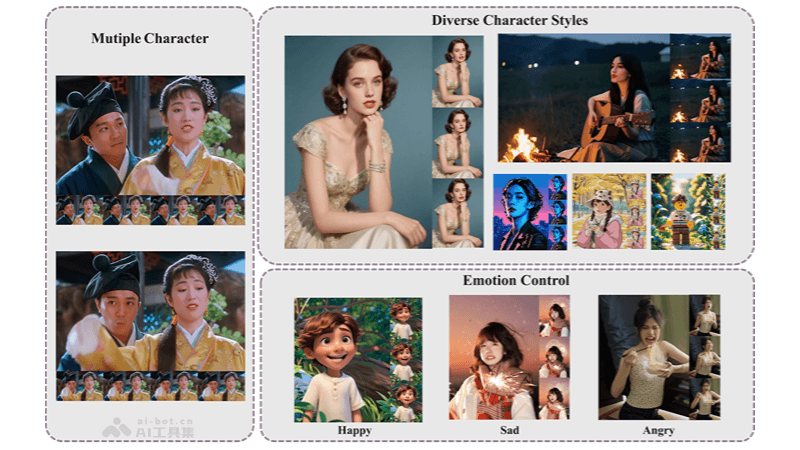

- 多角色互动:在多人互动场景中,模型能精准驱动多个角色,确保各角色的唇形、表情和动作与音频完美同步,实现自然的互动,可生成各种场景下的对话、表演等视频片段。

- 多风格支持:支持多种风格、物种和多人场景,包括赛博朋克、2D动漫和中国水墨画等,创作者可以轻松上传卡通角色或虚拟形象,生成风格化的动态视频,满足动漫、游戏等领域的创作需求。

HunyuanVideo-Avatar的技术原理

- 多模态扩散Transformer架构(MM-DiT):架构能同时处理多种模态的数据,如图像、音频和文本,实现高度动态的视频生成。通过“双流到单流”的混合模型设计,先独立处理视频和文本数据,再将它们融合,有效捕捉视觉和语义信息之间的复杂交互。

- 角色图像注入模块:取代传统的加法角色条件方法,解决了训练与推理之间的条件不匹配问题,确保生成视频中角色的动态运动和一致性。

- 音频情感模块(AEM):从情感参考图像中提取情感线索,将其转移到目标生成视频中,实现情感风格的精细控制。

- 面部感知音频适配器(FAA):通过潜在级别的面部掩码隔离音频驱动的角色,实现多角色场景下的独立音频注入,使每个角色能根据自己的音频进行独立的动作和表情生成。

- 时空压缩的潜在空间:基于Causal 3D VAE技术,将视频数据压缩成潜在表示,再通过解码器重构回原始数据,加速了训练和推理过程,提高了生成视频的质量。

- MLLM文本编码器:使用预训练的多模态大语言模型(MLLM)作为文本编码器,相比传统的CLIP和T5-XXL,MLLM在图像-文本对齐、图像细节描述和复杂推理方面表现更佳。

HunyuanVideo-Avatar的项目地址

- 项目官网:https://hunyuanvideo-avatar.github.io/

- Github仓库:https://github.com/Tencent-Hunyuan/HunyuanVideo-Avatar

- HuggingFace模型库:https://huggingface.co/tencent/HunyuanVideo-Avatar

- arXiv技术论文:https://arxiv.org/pdf/2505.20156

HunyuanVideo-Avatar的应用场景

- 产品介绍视频:企业可以根据产品特点和目标输入提示,快速生成高质量的广告视频。例如,化妆品广告可以展示产品效果,提升品牌知名度。

- 知识可视化:将抽象知识以视频形式呈现,增强教学效果。例如,数学教学中可以生成几何图形的旋转变形视频,帮助学生理解;语文教学中可以展现诗人创作的意境。

- 职业技能培训:生成模拟操作视频,帮助学员掌握操作要点。

- VR游戏开发:在VR游戏中生成逼真的环境和互动场景,例如古代遗迹探险。