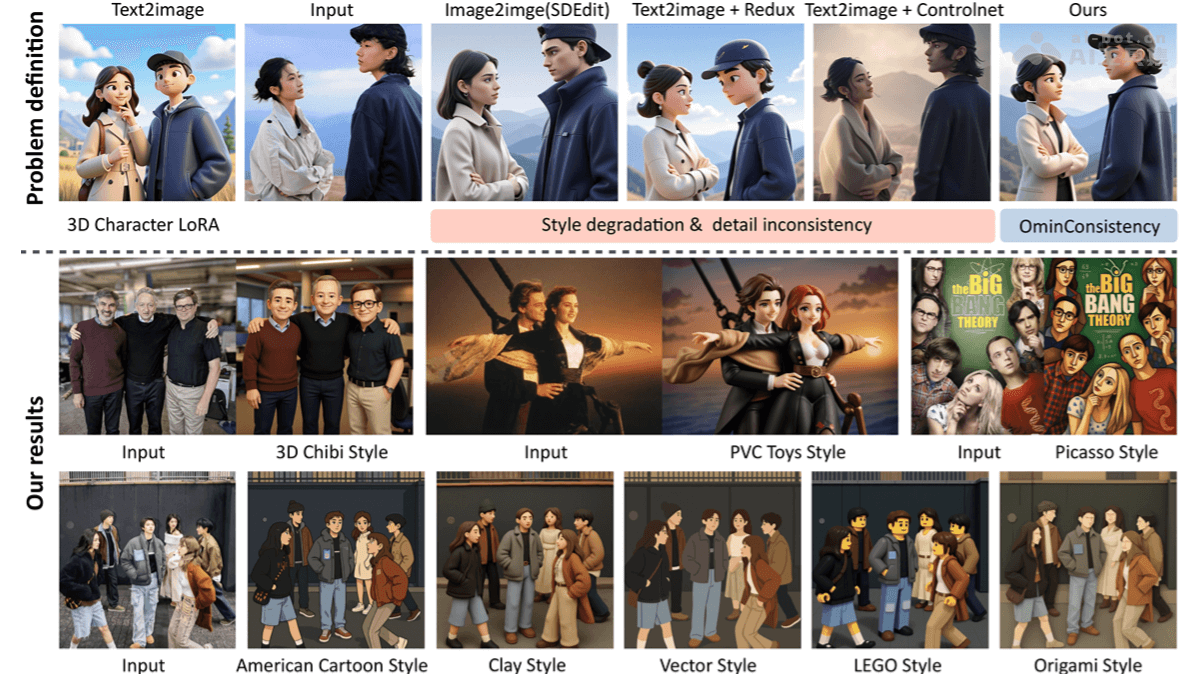

OmniConsistency是什么

OmniConsistency 是新加坡国立大学推出的图像风格迁移模型,能解决复杂场景下风格化图像的一致性问题。模型基于大规模配对的风格化数据进行训练,用两阶段训练策略,将风格学习与一致性学习解耦,在多种风格下保持图像的语义、结构和细节一致性。模型支持与任意风格的 LoRA 模块无缝集成,实现高效且灵活的风格化效果。OmniConsistency 在实验中展现出与 GPT-4o 相当的性能,且提供更高的灵活性和泛化能力。

OmniConsistency的主要功能

- 风格一致性:在多种风格下保持图像的风格一致性,避免风格退化。

- 内容一致性:在风格化过程中保留原始图像的语义和细节,确保内容的完整性。

- 风格无关性:与任意风格的 LoRA(Low-Rank Adaptation)模块无缝集成,支持多种风格的风格化任务。

- 灵活性:支持灵活的布局控制,无需依赖传统的几何约束(如边缘图、草图、姿态图)。

OmniConsistency的技术原理

- 两阶段训练策略:第一阶段(风格学习)独立训练多个风格特定的 LoRA 模块,每个模块专注于捕捉特定风格的独特细节。第二阶段(一致性学习)在配对数据上训练一致性模块,动态切换不同的风格 LoRA 模块,确保一致性模块专注于结构和语义的一致性,避免吸收特定风格的特征。

- 一致性 LoRA 模块:在条件分支中引入低秩适应(LoRA)模块,仅对条件分支进行调整,避免干扰主网络的风格化能力。用因果注意力机制,确保条件令牌在内部交互,主分支(噪声和文本令牌)保持干净的因果建模。

- 条件令牌映射(CTM):低分辨率条件图像引导高分辨率生成,基于映射机制确保空间对齐,减少内存和计算开销。

- 特征重用:在扩散过程中,缓存条件令牌的中间特征,避免重复计算,提高推理效率。

- 数据驱动的一致性学习:构建高质量的配对数据集,包含 22 种不同风格的 2,600 对图像,基于数据驱动的方式学习语义和结构的一致性映射。

OmniConsistency的项目地址

- GitHub仓库:https://github.com/showlab/OmniConsistency

- HuggingFace模型库:https://huggingface.co/showlab/OmniConsistency

- arXiv技术论文:https://arxiv.org/pdf/2505.18445

- 在线体验Demo:https://huggingface.co/spaces/yiren98/OmniConsistency

OmniConsistency的应用场景

- 艺术创作:将各种艺术风格(如动漫、油画、素描等)应用于图像,帮助艺术家快速生成风格化的作品。

- 内容生成:在内容创作中,快速生成符合特定风格的图像,提升内容的多样性和吸引力。

- 广告设计:为广告和营销材料生成风格一致的图像,提升视觉效果和品牌一致性。

- 游戏开发:快速生成游戏中的风格化角色和场景,提高开发效率。

- 虚拟现实(VR)和增强现实(AR):生成风格化的虚拟环境和元素,增强用户体验。