Playmate是什么

Playmate是广州趣丸科技团队推出的人脸动画生成框架。框架基于3D隐式空间引导扩散模型,用双阶段训练框架,根据音频和指令精准控制人物的表情和头部姿态,生成高质量的动态肖像视频。Playmate基于运动解耦模块和情感控制模块,实现对生成视频的精细控制,显著提升视频质量和情感表达的灵活性。Playmate在音频驱动肖像动画领域取得重大进展,提供对情感和姿态的精细控制,能生成多种风格的动态肖像,具有广泛的应用前景。

Playmate的主要功能

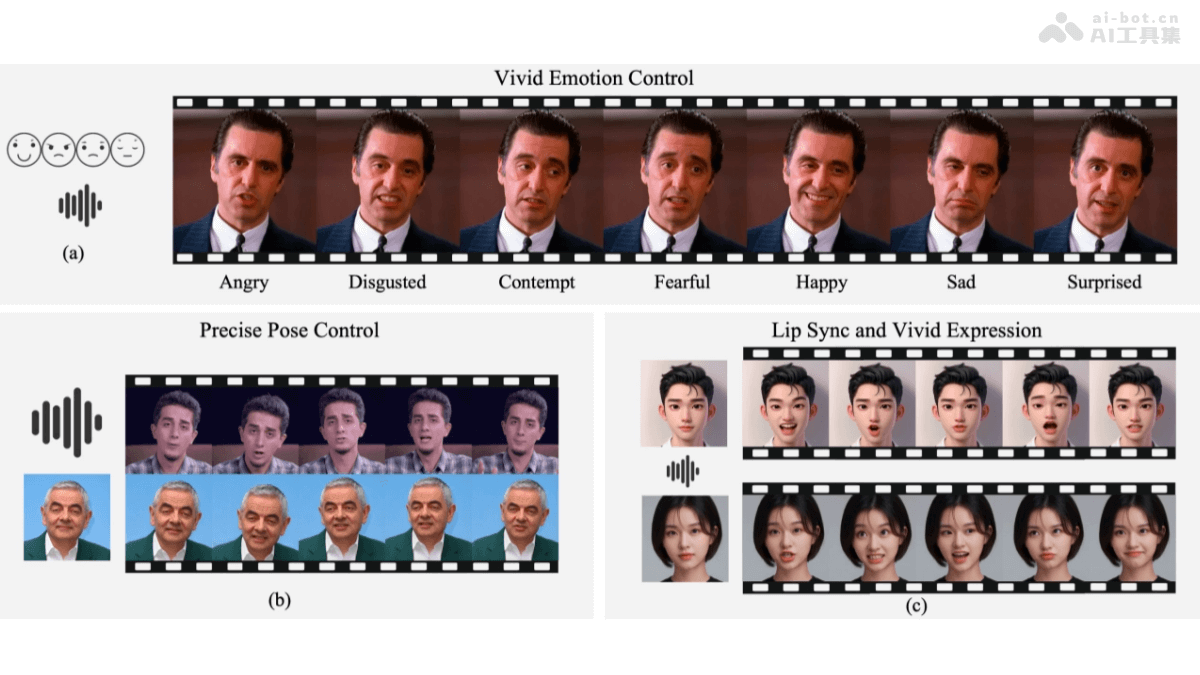

- 音频驱动:仅需一张静态照片和一段音频,生成对应的动态肖像视频,实现自然的口型同步和面部表情变化。

- 情感控制:根据指定的情感条件(如愤怒、厌恶、轻蔑、恐惧、快乐、悲伤、惊讶等)生成具有特定情感的动态视频。

- 姿态控制:支持基于驱动图像控制生成结果的姿态,实现头部的多种运动和姿势。

- 独立控制:实现对表情、口型和头部姿态的独立控制。

- 多样化风格:生成多种风格的动态肖像,包括真实人脸、动画、艺术肖像甚至动物,具有广泛的适用性。

Playmate的技术原理

- 3D隐式空间引导扩散模型:基于3D隐式空间表示,将面部属性(如表情、口型、头部姿态等)进行解耦。基于自适应归一化策略,进一步提高运动属性的解耦精度,确保生成的视频在表情和姿态上更加自然。

-

双阶段训练框架:

- 第一阶段:训练音频条件扩散变换器,直接从音频线索生成运动序列。基于运动解耦模块,实现对表情、口型和头部姿态的准确解耦。

- 第二阶段:引入情感控制模块,将情感条件编码到潜在空间中,实现对生成视频的精细情感控制。

- 情感控制模块:基于DiT块(Diffusion Transformer Blocks)实现情感控制模块,用两个DiT块结构,将情感条件融入到生成过程中,实现对情感的精细控制。用分类器自由引导(Classifier-Free Guidance, CFG)策略,基于调整CFG权重,平衡生成视频的质量和多样性。

- 高效的扩散模型训练:用预训练的Wav2Vec2模型提取音频特征,基于自注意力机制对齐音频与运动特征。基于正向和反向马尔可夫链,逐步向目标运动数据添加高斯噪声,用扩散变换器预测去除噪声,生成最终的运动序列。

Playmate的项目地址

- 项目官网:https://playmate111.github.io/Playmate/

- GitHub仓库:https://github.com/Playmate111/Playmate

- arXiv技术论文:https://arxiv.org/pdf/2502.07203

Playmate的应用场景

- 影视制作:生成虚拟角色动画、特效增强及角色替换,减少手工制作成本,提升特效真实感。

- 游戏开发:助力虚拟角色生成、互动剧情打造及NPC动画制作,增强游戏互动性和沉浸感。

- 虚拟现实(VR)和增强现实(AR):实现虚拟角色交互、虚拟会议及虚拟社交中的自然表情和口型同步,提升用户体验。

- 互动媒体:应用在直播、视频会议、虚拟主播及互动广告,让内容更生动有趣,增强互动性。

- 教育和培训:用在虚拟教师生成、模拟训练及语言学习,让教学内容更吸引学生,提供真实训练环境。