Qwen3-30B-A3B-Thinking-2507是什么

Qwen3-30B-A3B-Thinking-2507 是阿里通义开源的推理模型,专为复杂推理任务设计。模型拥有305亿参数,其中33亿被激活,支持256K原生上下文长度,能扩展至1M tokens。模型在数学、编程、多语言指令遵循等任务中表现出色,推理能力显著提升。Qwen3-30B-A3B-Thinking-2507 具备强大的通用能力,如写作、对话和工具调用。模型轻量级设计适合在消费级硬件上部署,且已在Qwen Chat开放体验。

Qwen3-30B-A3B-Thinking-2507的主要功能

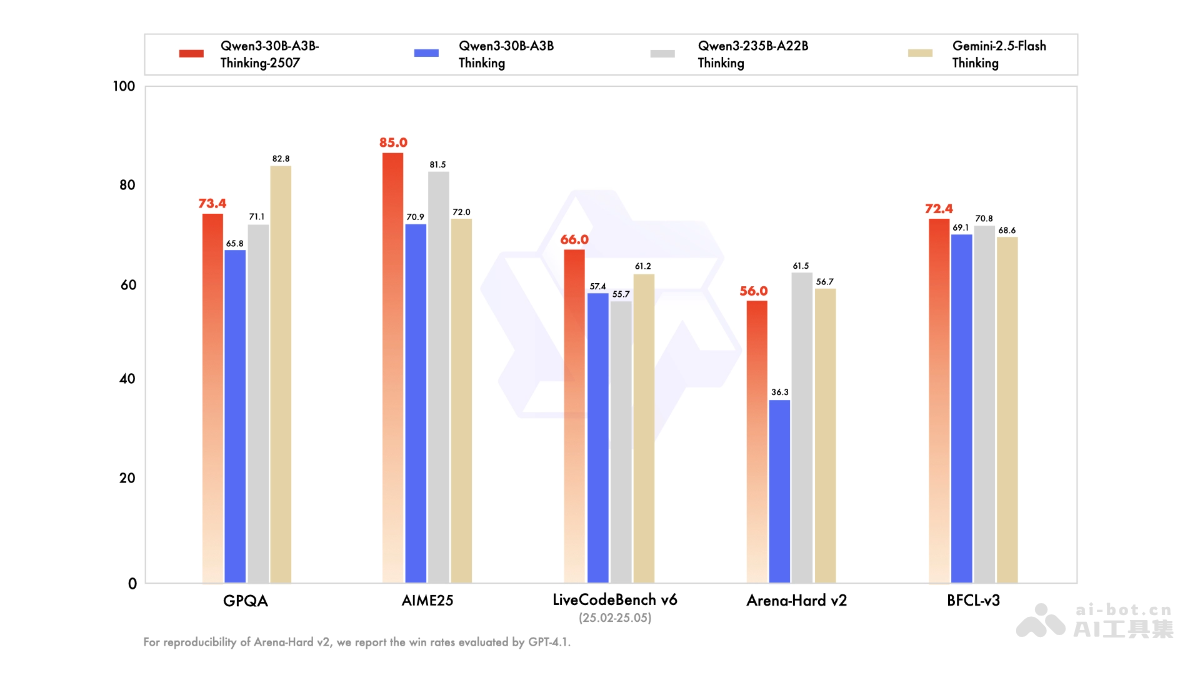

- 强大的推理能力:在逻辑推理、数学问题解决、科学推理等任务中表现出色,例如在AIME25数学评测中获得85.0的高分。在代码生成和理解方面也有显著表现,LiveCodeBench v6评测得分66.0。

- 通用能力全面升级:支持多语言指令遵循,能理解和生成多种语言的文本。

- 长文本理解能力:原生支持256K tokens的上下文长度,可扩展至1M tokens,适合处理长文本任务。

- 思考模式优化:增加思考长度,推荐在复杂推理任务中使用更长的思考预算,充分发挥模型的推理潜力。

- 工具调用和代理能力:支持工具调用,能通过Qwen-Agent等工具实现更复杂的任务自动化。

- 轻量级设计:适合在消费级硬件上本地部署,便于开发者在不同场景中使用。

Qwen3-30B-A3B-Thinking-2507的技术原理

- Transformer架构:用标准的Transformer架构,包含48层,每层有32个查询头(Q)和4个键值头(KV),支持高效的并行计算。

- 混合专家(MoE)机制:模型中包含128个专家,每次激活8个专家,基于动态路由机制选择最适合当前任务的专家,提高模型的灵活性和效率。

- 长上下文支持:通过优化内存管理和计算架构,原生支持256K tokens的上下文长度,可扩展至1M tokens,适合处理长文本任务。

- 思考模式:引入了“思考模式”,通过增加思考长度和优化推理过程,让模型在复杂任务中能生成更详细、更全面的推理路径。

- 预训练和后训练:模型经过大规模预训练,学习语言模式和常识知识。后训练阶段通过特定任务的微调,进一步提升模型在特定领域的表现。

Qwen3-30B-A3B-Thinking-2507的项目地址

- HuggingFace模型库:https://huggingface.co/Qwen/Qwen3-30B-A3B-Thinking-2507

Qwen3-30B-A3B-Thinking-2507的应用场景

- 智能辅导:为学生提供详细的解题步骤和推理过程,快速攻克复杂的数学和科学难题,提升学习效率和理解能力。

- 软件开发:模型依据开发人员的功能需求描述,自动生成代码框架或片段,并提出优化建议,有效提高软件开发的效率和质量。

- 医学文献解读:快速解读医学文献,提取关键信息并提供简明总结,助力医生和研究人员节省时间,更好地应用于临床实践或研究。

- 创意写作:在创作小说、剧本或文案时,生成创意文本,提供情节发展、角色设定和对话内容,激发创作者的灵感,丰富作品的层次。

- 市场分析:根据市场分析师提供的数据和问题,生成市场研究报告,分析行业趋势、竞争对手优势和消费者需求,为企业提供数据驱动的决策支持。