Qwen3-Coder-Flash是什么

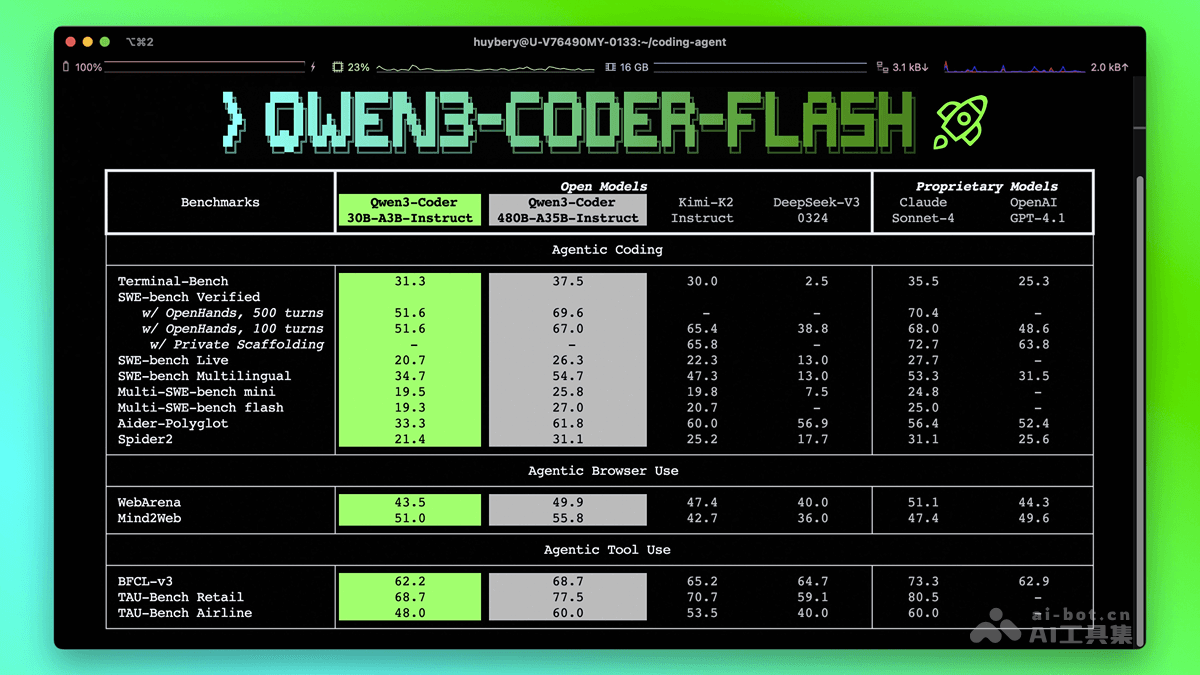

Qwen3-Coder-Flash 是阿里通义千问团队推出的高性能编程模型,全称 Qwen3-Coder-30B-A3B-Instruct。模型具备卓越的 Agentic 能力,擅长代理式编程、工具调用等任务,接近顶配版 Qwen3-Coder-480B-A35B-Instruct 及Claude Sonnet-4、GPT4.1等领先闭源模型。模型支持 256K tokens 的长上下文理解,能扩展至 1M tokens,适合仓库级代码理解,避免上下文断层。模型优化了函数调用格式,支持 Qwen Code、CLINE 等平台。目前,模型能通过Qwen Chat平台访问且已开源,开发者能在本地硬件部署,构建专属代码助手。

Qwen3-Coder-Flash的主要功能

- 卓越的Agentic能力:Qwen3-Coder-Flash在代理式编程、工具调用和浏览器使用等任务中表现出色,能高效完成复杂编程任务。

- 长上下文理解:原生支持256K tokens,能扩展至1M tokens,适合处理大型代码库,避免上下文断层。

- 多平台支持:优化函数调用格式,支持Qwen Code、CLINE等平台,方便开发者在不同环境中使用。

- 高效代码生成:提供高质量的代码生成能力,支持多种编程语言,帮助开发者快速实现功能。

- 本地部署:开源模型,支持在本地硬件上部署,开发者能构建专属的代码助手。

Qwen3-Coder-Flash的技术原理

- 模型架构:基于Causal Language Models架构,具备305亿参数,其中33亿参数被激活。模型共有48层,使用分组查询注意力(Grouped Query Attention, GQA)机制,其中查询头(Q)数量为32,键值头(KV)数量为4。模型配备了128个专家(experts),每次激活8个专家。让模型在处理复杂的编程任务时能高效地分配计算资源,同时保持强大的语言生成能力。

- 训练阶段:在预训练阶段,模型在大规模代码数据上进行无监督学习,基于学习代码的语法和语义结构,掌握编程语言的通用规则。后训练阶段针对特定的编程任务进行微调,进一步提升模型在实际应用场景中的表现。分阶段训练方式使模型兼顾通用性和专业性,适应多样化的编程需求。

- 长上下文处理:模型原生支持256K tokens的上下文长度,基于YaRN技术扩展至1M tokens。使模型能理解和处理大型代码库,避免因上下文断层导致的代码生成错误。长上下文支持对于仓库级代码理解和复杂项目开发尤为重要,能显著提升编程效率和代码质量。

- Agentic能力:模型具备强大的Agentic能力,支持代理式编程、工具调用和浏览器使用等任务。模型根据用户指令自动调用外部工具(如API、数据库等),通过浏览器获取实时信息,增强编程能力。让模型能够生成代码,还能与外部系统交互,完成更复杂的编程任务。

Qwen3-Coder-Flash的项目地址

- HuggingFace模型库:https://huggingface.co/Qwen/Qwen3-Coder-30B-A3B-Instruct

Qwen3-Coder-Flash的应用场景

- 代码生成与辅助编程:为开发者快速生成代码片段和优化建议,减少重复工作,提升编程效率。

- 自动化编程任务:自动生成测试代码和脚本,实现自动化操作,提高开发和测试效率。

- 项目开发与维护:凭借长上下文理解能力,快速定位问题并提供重构建议,提升项目维护效率。

- 教育与培训:在编程教学中实时生成代码并提供解释,帮助学生快速理解编程概念。

- 企业级应用:辅助代码审查和生成自动化测试脚本,助力企业提升代码质量和开发效率。