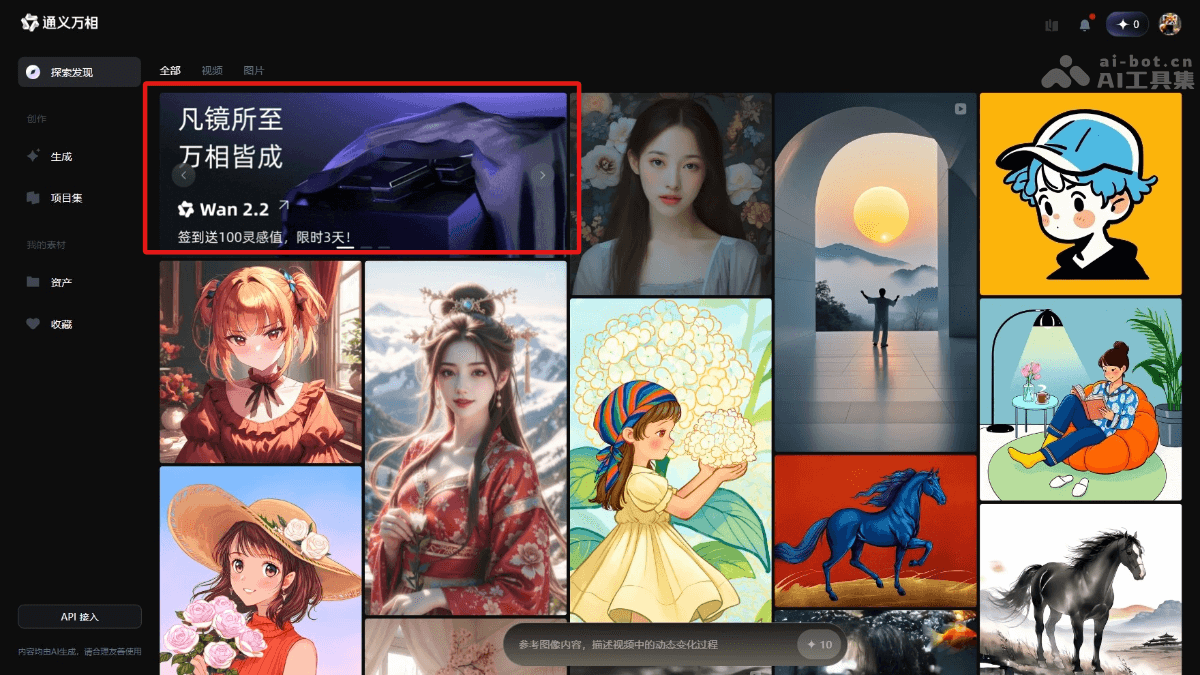

通义万相2.2是什么

通义万相2.2(Wan2.2)是阿里巴巴开源的先进AI视频生成模型。共开源文生视频(Wan2.2-T2V-A14B)、图生视频(Wan2.2-I2V-A14B)和统一视频生成(Wan2.2-IT2V-5B)三款模型,总参数量达270亿。模型首次引入混合专家(MoE)架构,有效提升生成质量和计算效率,同时首创电影级美学控制系统,能精准控制光影、色彩、构图等美学效果。此次开源的5B参数紧凑视频生成模型,支持文本和图像生成视频,能在消费级显卡上运行,基于高效的3D VAE架构,实现高压缩率和快速生成高清视频的能力。目前,开发者可通过GitHub、HuggingFace等平台获取模型和代码,企业可通过阿里云百炼调用API进行应用开发,用户能在通义万相官网和通义APP直接体验。

通义万相2.2的主要功能

- 文生视频(Text-to-Video):根据输入的文本描述生成相应的视频内容。例如,输入“一只猫在草地上奔跑”,模型能生成一段符合描述的视频。

- 图生视频(Image-to-Video):根据输入的图片生成视频,模型根据图片内容生成动态场景,让图片“活”起来。

- 统一视频生成(Text-Image-to-Video):结合文本和图片生成视频,同时用文本描述和图片信息,生成更精准的视频内容。

- 电影级美学控制:通过光影、色彩、构图、微表情等控制,生成具有专业电影质感的视频。用户通过输入相关关键词(如“暖色调”“中心构图”)定制视频的美学风格。

- 复杂运动生成:能生成复杂的运动场景和人物交互,提升视频的动态表现力和真实感。

通义万相2.2的技术原理

- 混合专家(MoE)架构:引入MoE架构,将模型分为高噪声专家和低噪声专家。高噪声专家负责视频的整体布局,低噪声专家负责细节完善。在保持计算成本不变的情况下,大幅提升模型的参数量和生成质量。

- 扩散模型(Diffusion Model):基于扩散模型作为基础架构,通过逐步去除噪声来生成高质量的视频内容。MoE架构与扩散模型结合,能进一步优化生成效果。

- 高压缩率3D VAE:为提高模型的效率,通义万相2.2基于高压缩率的3D变分自编码器(VAE)。架构实现了时间、空间的高压缩比,让模型能在消费级显卡上快速生成高清视频。

- 大规模数据训练:模型在大规模数据集上进行训练,包括更多的图像和视频数据,提升模型在多种场景下的泛化能力和生成质量。

- 美学数据标注:基于精心标注的美学数据(如光影、色彩、构图等),模型能生成具有专业电影质感的视频内容,满足用户对视频美学的定制需求。

通义万相2.2的项目地址

- GitHub仓库:https://github.com/Wan-Video/Wan2.2

- HuggingFace模型库:https://huggingface.co/Wan-AI/models

如何使用通义万相2.2

- 访问官网: 访问通义万相的官方网站或下载通义APP进行体验。

- 选择模型:在模型选择下拉框中选择通义万相2.2。

-

选择体验模式:

- 文生视频(Text-to-Video):输入文本描述,例如“一只猫在草地上奔跑”,点击生成按钮,能看到生成的视频。

- 图生视频(Image-to-Video):上传一张图片,模型根据图片内容生成动态视频。

- 统一视频生成(Text-Image-to-Video):结合文本描述和上传的图片,生成更精准的视频内容。

- 调整参数(可选):用户根据需要调整视频的分辨率、帧率等参数。用电影级美学控制系统,通过输入关键词(如“暖色调”“中心构图”)定制视频的美学风格。

- 查看生成结果:生成的视频直接在网页上显示,用户能下载或分享生成的视频。

通义万相2.2的应用场景

- 短视频创作:创作者快速生成吸引人的短视频内容,用于社交媒体平台,节省创作时间和成本。

- 广告与营销:广告公司和品牌生成高质量的广告视频,提升广告效果和品牌影响力。

- 教育与培训:教育机构和企业生成生动的教育视频和培训材料,提升学习效果和培训质量。

- 影视制作:影视制作团队快速生成场景设计和动画片段,提升创作效率,降低制作成本。

- 新闻与媒体:新闻机构和媒体生成动画和视觉效果,增强新闻报道的视觉效果和观众参与度。