HunyuanPortrait是什么

HunyuanPortrait 是腾讯 Hunyuan 团队联合清华大学、中山大学和香港科技大学等机构共同推出的基于扩散模型的框架,用在生成高度可控且逼真的肖像动画。基于给定一张肖像图片作为外观参考和视频片段作为驱动模板,根据驱动视频中的面部表情和头部姿势动画化参考图片中的人物。HunyuanPortrait 在时间一致性和可控性方面优于现有方法,展现出强大的泛化性能,能有效解耦不同图像风格下的外观和运动,广泛用在虚拟现实、游戏和人机交互等领域。

HunyuanPortrait的主要功能

- 高度可控的肖像动画生成:基于单张肖像图片作为外观参考和视频片段作为驱动模板,精确地将驱动视频中的面部表情和头部姿势转移到参考肖像中,生成自然流畅的动画。

- 强大的身份一致性保持:在面部结构和运动强度存在显著差异的情况下,保持参考肖像的身份特征,避免身份失真。

- 逼真的面部动态捕捉:捕捉微妙的面部表情变化,如眼神方向、嘴唇同步等,生成高度逼真的肖像动画。

- 时间一致性优化:生成的视频在时间上具有高度的连贯性和平滑性,避免背景抖动和模糊等问题。

- 风格泛化能力:适应不同的图像风格,包括动漫风格和真实照片风格,具有广泛的适用性。

HunyuanPortrait的技术原理

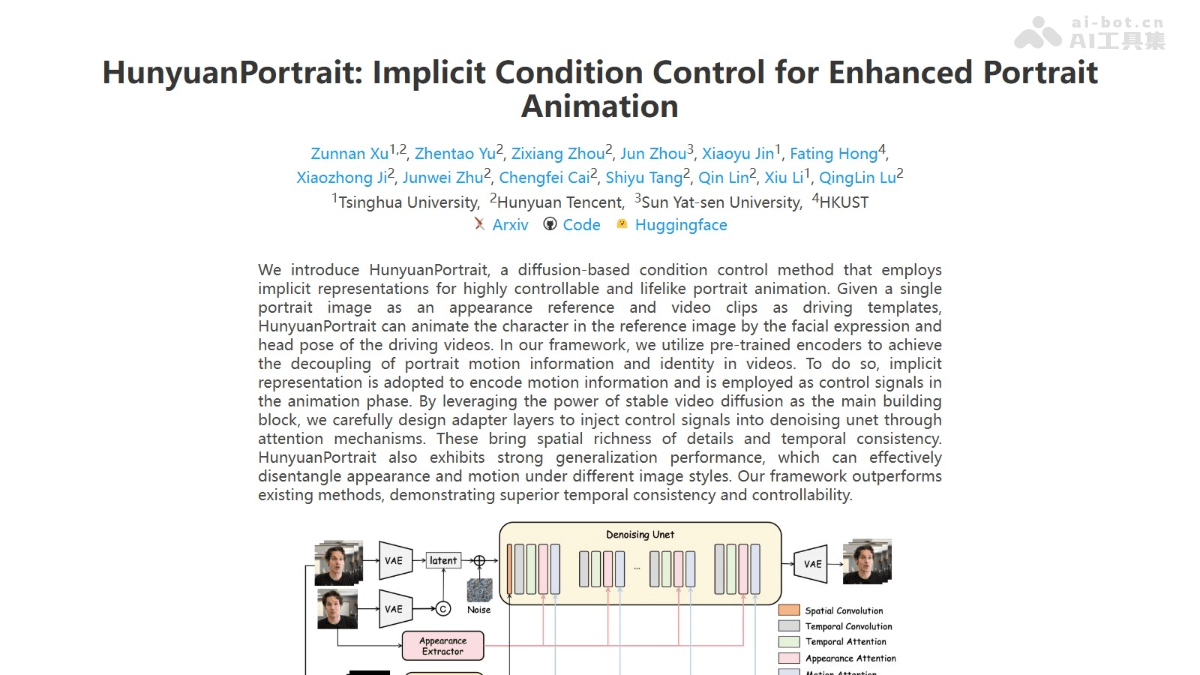

- 隐式条件控制:用隐式表示编码运动信息,更好地捕捉复杂的面部运动和表情变化,避免因关键点提取不准确导致伪影和失真。将编码后的运动信息作为控制信号,基于注意力机制注入到去噪 U-Net 中,实现对动画生成过程的精细控制。

- 稳定的视频扩散模型:基于扩散模型的框架,在潜在空间中进行扩散和去噪过程,提高生成质量和训练效率。用 VAE 将图像从 RGB 空间映射到潜在空间,基于 UNet 进行去噪处理,生成高质量的视频帧。

- 增强的特征提取器:基于估计运动强度(如面部表情的扭曲程度和头部运动的幅度)增强运动特征的表示,提高对不同运动强度的适应能力。结合 ArcFace 和 DiNOv2 背景,用多尺度适配器(IMAdapter)增强肖像的身份一致性,确保生成的动画在不同帧中保持一致的身份特征。

- 训练和推理策略:基于颜色抖动、姿态引导等技术增强训练数据的多样性,提高模型的泛化能力。用多种增强训练策略,如随机移除某些骨骼边缘,提高模型在不同输入条件下的稳定性。

- 注意力机制:在 UNet 中引入多头自注意力和交叉注意力机制,增强模型对空间和时间信息的感知能力,提高生成视频的细节丰富度和时间一致性。

HunyuanPortrait的项目地址

- 项目官网:https://kkakkkka.github.io/HunyuanPortrait/

- GitHub仓库:https://github.com/Tencent-Hunyuan/HunyuanPortrait

- HuggingFace模型库:https://huggingface.co/tencent/HunyuanPortrait

- arXiv技术论文:https://arxiv.org/pdf/2503.18860

HunyuanPortrait的应用场景

- 虚拟现实(VR)和增强现实(AR):创建逼真的虚拟角色,增强用户体验。

- 游戏开发:生成个性化的游戏角色,提升玩家的沉浸感。

- 人机交互:开发更自然的虚拟助手和客服机器人,增强交互效果。

- 数字内容创作:用在视频制作、广告和影视特效,快速生成高质量的动画内容。

- 社交媒体和娱乐:用户将自己的照片制作成动态表情包或虚拟形象,增加互动性。

- 教育和培训:创建个性化的虚拟教师或培训角色,提供更生动的教学体验。